Rédaction

Date

Partenaire(s)

Présenté au 92e Congrès de l’Acfas, ce projet se situe au croisement de l’intelligence artificielle et de la communication non verbale : Azzahrae El Khiati y explore comment traduire la parole en gestes humains naturels. En partenariat avec OVA, la programmeuse-chercheuse au CDRIN a testé trois modèles d’IA capables de synchroniser mouvement et discours en temps réel. Si les résultats sont prometteurs, des défis demeurent — latence, expressivité, adaptation culturelle — mais la voie est tracée vers des interactions virtuelles plus vivantes.

Entre les mots, il y a les gestes. Ils soulignent, traduisent, parfois contredisent. Et lorsqu’ils manquent, le dialogue perd de sa richesse — même entre humains et machines.

Faire en sorte qu’un avatar virtuel réagisse non seulement avec des mots, mais aussi avec des gestes cohérents, expressifs et crédibles: c’est précisément le défi que j’ai relevé dans le cadre de mon projet de recherche au CDRIN, en collaboration avec OVA. Mon objectif était de valider des modèles innovants d’intelligence artificielle capables de traduire la voix en gestes humains en temps réel.

L’importance des gestes dans l’interaction homme-machine

Dans nos échanges quotidiens, le langage corporel est essentiel à une communication efficace. Avec l’émergence de la réalité virtuelle, des agents conversationnels et de la robotique sociale, reproduire fidèlement ces gestes devient incontournable pour créer des interactions immersives et naturelles. Pourtant, générer automatiquement des gestes expressifs à partir d’une simple voix est complexe : les modèles doivent comprendre non seulement ce que nous disons, mais aussi comment nous le disons, captant les nuances émotionnelles, intentionnelles et culturelles.

Ma mission: valider les performances et identifier les limites

Pour répondre à cette problématique, j’ai testé expérimentalement trois modèles audio-to-motion : DiffSHEG, Audio2Gesture, et Speech2Gesture. Mon objectif était clair : vérifier leur capacité à produire des gestes naturels synchronisés avec la parole en temps réel, tout en mettant en lumière leurs limites actuelles, comme la latence perceptible, l’ambiguïté émotionnelle et les défis d’adaptation interculturelle.

Mon objectif était clair: vérifier leur capacité à produire des gestes naturels synchronisés avec la parole en temps réel, tout en mettant en lumière leurs limites actuelles, comme la latence perceptible, l’ambiguïté émotionnelle et les défis d’adaptation interculturelle.

Mon approche: de la voix à l’action

J’ai commencé par collecter un corpus d’enregistrements audio-mouvement, capturant des gestes émotionnellement riches. Ensuite, j’ai effectué une analyse rigoureuse, tant quantitative que qualitative, dans un environnement immersif de simulation conversationnelle sous Unity, ce qui m’a permis de mesurer précisément la fluidité, la précision temporelle et la cohérence des mouvements générés.

Résultats clés de mon étude

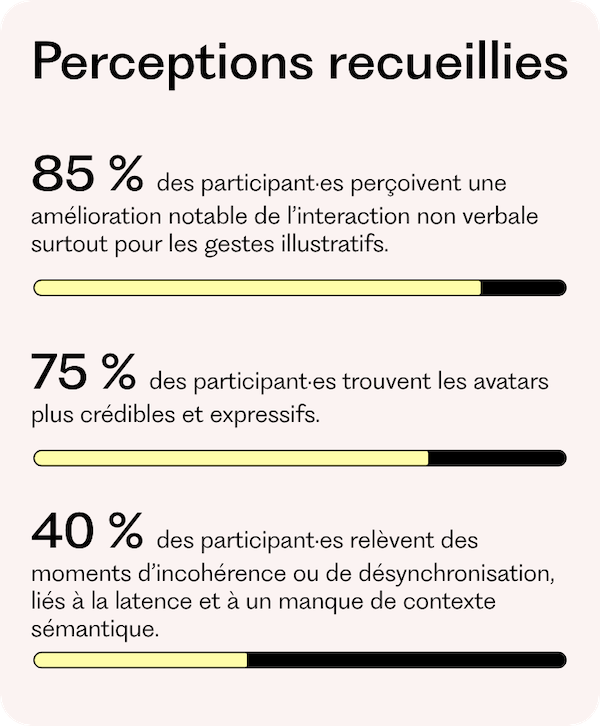

Les modèles que j’ai évalués ont montré un potentiel prometteur en générant des gestes globalement alignés avec les émotions véhiculées par la voix. Toutefois, j’ai identifié plusieurs défis:

- Une latence moyenne de 350 à 500 ms, qui empêche encore une interaction totalement fluide.

- Des difficultés à modéliser précisément les nuances émotionnelles implicites, telles que l’ironie ou l’humour.

- Une variabilité notable selon les contextes culturels, ce qui souligne l’importance d’une meilleure adaptation interculturelle.

Un potentiel immense à long terme avec des défis persistants

Ces résultats démontrent clairement que l’IA audio-to-motion peut révolutionner les interactions virtuelles en apportant une dimension gestuelle naturelle et pertinente. Cependant, réduire la latence, affiner l’expressivité émotionnelle et améliorer l’adaptation culturelle restent essentiels avant une adoption plus large.

Les limites des modèles audio to motion

La portée statistique de ces résultats est limitée par la petite taille de l’échantillon (N=10). Des recherches à plus grande échelle seront nécessaires pour confirmer et généraliser mes conclusions.

Ce projet trace la voie vers des interactions homme-machine plus expressives et naturelles, où l’intelligence artificielle ne se contenterait plus de comprendre les mots, mais saurait aussi en épouser les gestes.

Les applications sont nombreuses et déjà envisageables. Dans un musée interactif, un guide virtuel pourrait synchroniser sa gestuelle à son discours, captant plus naturellement l’attention des visiteurs. Dans un jeu vidéo, un personnage non joueur (PNJ) pourrait moduler ses mouvements en fonction de l’intonation de sa voix, rendant l’échange plus crédible, plus incarné.

La recherche appliquée Des sons aux gestions: valider l’IA pour des mouvements humains naturels de la chercheuse-programmeuse Azzahrae El Khiati est présentée en communication affichée lors du Colloque de l’ARC dans le cadre du 92e Congrès de l’Acfas, École de technologie supérieure à Montréal, 5 mai 2025.