Rédaction

Date

De la modélisation 3D à la simulation environnementale : points saillants pour l’apprentissage machine en contexte de production

Du 13 au 19 juillet, la conférence ICML 2025 (International Conference on Machine Learning) s’est tenue à Vancouver. Des milliers de chercheuses et chercheurs s’y sont rassemblés. Des praticiennes et praticiens aussi. Ensemble, ils ont exploré les percées récentes en intelligence artificielle et en apprentissage machine.

ICML est l’une des conférences les plus influentes au monde dans ce domaine. Chaque année, elle redessine les contours de l’IA : modèles fondamentaux, apprentissage profond, systèmes hybrides, domaines appliqués.

Le CDRIN y était. Centre de recherche appliquée basé au Québec, il œuvre à la croisée de l’IA, des technologies 3D et des systèmes interactifs. Sa présence visait un objectif clair : identifier ce qui, dans ces innovations, peut répondre aux défis concrets de l’industrie et de la recherche.

Les enseignements sont nombreux. Pour celles et ceux qui travaillent sur la simulation, la vision par ordinateur ou les modèles en production, ICML a offert des pistes solides : mieux exploiter les données, renforcer la robustesse, fluidifier les processus de R&D.

Voici ce que les chercheurs Sherry Taheri et Olivier Leclerc en retiennent. Une lecture axée sur le transfert de connaissances, les outils utilisables, et le rôle croissant de l’IA appliquée — ici, au Québec, et ailleurs.

ICML 2025 a présenté plusieurs avancées pour adapter les grands modèles de langage (LLM) à de nouvelles tâches. Quelles techniques récentes vous ont semblé les plus pertinentes pour les praticiens et praticiennes qui disposent de ressources limitées ou qui travaillent sur des appareils en périphérie (ajustement de paramètres, compression de modèles, ou adaptation à faible rang)?

Olivier Leclerc : La recherche sur ParetoQ m’a semblé particulièrement éclairante. Elle explore les compromis optimaux entre la taille d’un modèle et sa précision. Leur approche a permis de créer un modèle ternaire de 600 millions de paramètres, plus performant qu’un modèle de référence de 3 milliards de paramètres.

Ce modèle atteint une précision optimale à différents niveaux de quantification — 1 bit, 1,58 bit, 2 bits, 3 bits, 4 bits — ce qui le rend très adaptable. Cette efficacité ouvre la voie à des modèles linguistiques plus rapides et plus précis, même lorsqu’ils tournent directement sur des appareils mobiles. Ils ont d’ailleurs publié une version démonstrateur, MobileLLM, pour illustrer le concept.

Sherry Taheri : Je n’ai pas assisté à des conférences spécifiquement consacrées à l’efficacité, mais j’ai rencontré l’équipe derrière Ollama, une plateforme que j’utilise souvent.

Cela dit, ce qui m’a surtout interpellée en lien avec la première partie de la question, ce sont les recherches sur la capacité des LLM à comprendre l’espace et à suivre l’état du monde. Je travaille en ce moment sur un projet qui aborde ces mêmes questions, alors voir ce que d’autres équipes ont trouvé, c’était vraiment stimulant.

2. L’apprentissage par renforcement (RL) a occupé une place importante à ICML, notamment en robotique et pour les agents autonomes. Quelles approches vous ont semblé les plus prometteuses pour améliorer des systèmes réels, en automatisation, fabrication ou contrôle visuel?

Olivier : L’apprentissage par renforcement (RL) se fait généralement dans des simulateurs où les modèles peuvent s’entraîner à l’infini, mais dans les applications réelles, il doit extraire un maximum d’information à partir d’un nombre limité d’exemples.

J’ai aimé découvrir de nouvelles idées visant à améliorer ce que les chercheurs appellent «l’efficacité optimale de l’échantillonnage», c’est-à-dire la capacité d’un agent à apprendre à partir de moins d’exemples. Je débute encore en apprentissage par renforcement, mais la direction semble prometteuse : une meilleure généralisation avec moins de données !

Deux exemples :

- Papers Actor-Critics Can Achieve Optimal Sample

- Leveraging Sparsity for Sample-Efficient Preference Learning: A Theoretical Perspective

Un autre point marquant fut un article du MILA intitulé « Network Sparsity Unlocks the Scaling Potential of Deep Reinforcement Learning ». Il montre que l’introduction de la sparsité (neurones désactivés ou zones vides dans le réseau) permet aux modèles plus volumineux de mieux évoluer en apprentissage par renforcement. Jusqu’ici, les performances plafonnaient avec des architectures plus grandes. Cela ouvre un fort potentiel pour les applications futures !

3. Avec votre expérience des systèmes de vision et de la reconstruction 3D, quels travaux présentés à ICML vous ont semblé les plus applicables à vos défis actuels dans ce domaine ?

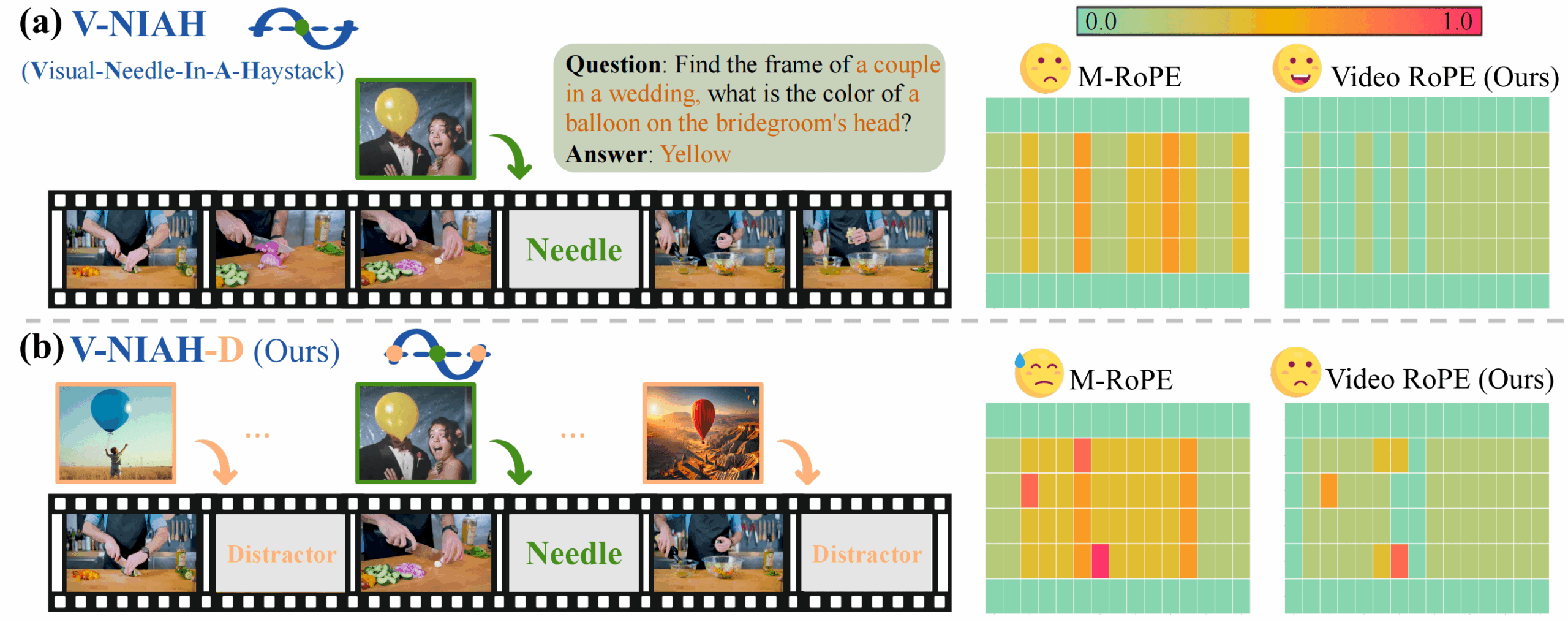

Olivier : Le projet VideoRoPE m’a paru particulièrement utile. Il prolonge les modèles de type transformeur en leur donnant une compréhension spatiale (y compris en 3D) et temporelle. Cela ouvre la voie à une capacité de raisonnement plus approfondi sur le contenu vidéo qu’auparavant.

Par exemple, vous pourriez demander : « Trouve la scène où un couple est à un mariage, quelle est la couleur du ballon au-dessus de la tête du marié ? » Même si ce détail n’apparaît qu’une fraction de seconde à l’écran, le modèle peut l’extraire et le relier.

4. ICML a présenté plusieurs avancées en prévision de séries temporelles, dans des domaines comme le climat ou la finance. Ces méthodes sont-elles assez adaptables pour des projets industriels concrets ?

Olivier : Avant la conférence, je n’avais pas réalisé à quel point les modèles fondamentaux pour séries temporelles pouvaient être polyvalents.

La présentation de Sundial m’a vraiment surpris : c’est un modèle fondamental qui prédit les prochaines valeurs dans n’importe quelle séquence, sans ré-entraînement requis.

Un seul et même modèle pourrait ainsi s’appliquer à des données météo, à des marchés financiers, ou à toute autre série chronologique. Je ne lui ferais pas encore entièrement confiance pour des tâches critiques en industrie, mais je le verrais bien pour générer rapidement des données synthétiques plausibles, afin d’accélérer un développement.

Sherry : Je suis d’accord. Je soulignerais aussi la présentation d’Ana Lucic, qui a parlé d’Aurora, un modèle fondamental pour les systèmes terrestres, développé par Microsoft.

Les prévisions des systèmes terrestres reposent souvent sur des modèles complexes, gourmands en ressources, et peu adaptables. Aurora, lui, s’attaque à ces limites : il permet à quiconque de générer des prévisions environnementales utiles, tout en réduisant la consommation de ressources.

Une fois pré-entraîné, le modèle peut être ajusté sur des tâches précises : chimie atmosphérique, qualité de l’air, modélisation des vagues, suivi des ouragans, prévisions météo. Résultat : des prévisions ciblées à un coût bien plus faible.

C’est un excellent exemple d’un modèle d’IA qui réduit à la fois l’effort de calcul et l’effort de développement.

Les poids préentraînés et ajustés d’Aurora sont d’ailleurs disponibles sur Hugging Face.

La forte présence des firmes de trading à ICML montre aussi combien l’IA devient essentielle en finance et en négociation algorithmique.

5. La fiabilité des modèles reste une préoccupation majeure. Quelles approches nouvelles en calibration, robustesse ou d’atténuation des biais vous ont semblé les plus utiles pour les équipes d’IA appliquée qui cherchent à construire des systèmes sûrs et dignes de confiance ?

Sherry : J’ai vu plusieurs projets intéressants en apprentissage fédéré, en confidentialité différentielle et en adversarial ML. Ce sont des domaines que je connais un peu moins, donc je me suis plutôt attardée aux affiches qui traitaient de biais et d’équité.

Un aspect marquant : les modèles texte-vers-image ont encore tendance à mal représenter les éléments culturels. Ce constat montre l’importance de développer des IA plus sensibles à la diversité culturelle, ainsi que de meilleurs outils d’évaluation. Il faut que les contenus générés par l’IA puissent refléter fidèlement différentes cultures. Sinon, on risque de propager des stéréotypes, voire de déformer la réalité.

Un article illustrait très bien ce problème : “CulturalFrames: Assessing Cultural Expectation Alignment in Text-to-Image Models and Evaluation Metrics« .

6. Avez-vous remarqué des progrès en robustesse, inférence en temps réel ou la généralisation, qui pourraient faciliter le déploiement de l’IA, notamment pour de petites ou moyennes équipes en jeu vidéo ou en R&D appliquée ?

Sherry : Pour être honnête, je n’ai pas vu de recherche qui me semble immédiatement exploitable en production.

Il faut dire que certains résultats peuvent être très contextuels, voire embellis, et nécessitent souvent une longue validation.

Cela dit, je crois que tout contenu qui aide les praticiens à mieux comprendre les outils qu’ils utilisent déjà a beaucoup de valeur. Un exemple : la conférence de Sergey Ioffe, l’inventeur de la normalisation de lot (BatchNorm).

C’est une technique qu’on utilise tout le temps, alors l’entendre raconter son origine et son évolution, c’était particulièrement éclairant.

7. Plusieurs sessions ont porté sur des approches centrées sur les données. Quelles avancées pourraient, selon vous, modifier la façon dont les studios ou laboratoires abordent l’acquisition de données et l’entraînement de leurs modèles ?

Olivier : Une piste prometteuse est l’analyse des gradients aberrants (papier sur l’Outlier Gradient Analysis). Elle permet de détecter les exemples nuisibles dans un jeu de données d’entraînement. Parfois, quelques exemples seulement suffisent à fausser l’apprentissage du modèle. En les retirant, on améliore la précision. J’ai déjà vu ce genre de problème en pratique, traité de façon empirique — alors avoir une méthode plus rigoureuse, c’est précieux.

Sherry : On entend souvent parler de la puissance des jeux de données massifs. Mais plus de données, ce n’est pas toujours la meilleure, ni la seule, manière d’améliorer un modèle. Comme je le disais dans la question précédente, augmenter les données de pré-entraînement peut parfois nuire aux performances sur les tâches aval.

Même sans accès à des données de haute qualité, on peut progresser. J’ai trouvé la présentation sur l’hypothèse Delta Learning très stimulante : elle propose d’apprendre à partir de différences entre données faibles et encore plus faibles, grâce à l’apprentissage par préférences.

Ce n’est donc pas toujours une question d’échelle. Parfois, c’est la façon d’aborder le problème qui ouvre la voie à des modèles plus efficaces.

8. L’acquisition et l’annotation de données demeurent des préoccupations majeures pour les CTO, surtout pour l’entraînement de modèles avancés. Quelles bonnes pratiques ou quels outils présentés à ICML pourraient aider à simplifier ces étapes, notamment dans des contextes créatifs ou scientifiques ?

Olivier : Un article m’a particulièrement marqué: Improving the Scaling Laws of Synthetic Data with Deliberate Practice. Il propose une méthode structurée pour générer des données synthétiques via un modèle de diffusion. Le but est d’explorer les zones limites de l’apprentissage, et non de produire en masse. Résultat : le modèle généralise mieux une fois en production, sans ajout de vraies données d’entraînement.

Sherry : Cette année, ICML a beaucoup misé sur la curation des données, avec une forte présence de startups spécialisées. J’ai apprécié une présentation qui montrait comment combiner un modèle de langage de base avec un modèle affiné par instruction pour produire des données synthétiques fiables et diversifiées.

Autre moment marquant : la conférence de James Zou, qui expliquait comment constituer un jeu de données pour le raisonnement médical — un domaine où les données sont rares — à partir de sources variées comme des rapports cliniques, des vidéos pédagogiques sur YouTube ou des discussions sur Twitter/X.

9. Les sciences maritimes et environnementales posent des défis uniques en matière de données et de modélisation. Avez-vous vu à ICML des pistes qui pourraient répondre à ces besoins, voire ouvrir la porte à un transfert technologique vers le secteur du divertissement ?

Olivier : Le suivi d’individus est un besoin commun aux deux domaines, souvent avec peu de données d’apprentissage. C’est pourquoi j’ai trouvé Efficient Track Anything très intéressant : un modèle zero-shot, donc utilisable sans entraînement spécifique sur les données cibles. Il pourrait servir à générer des données d’entraînement plus variées pour un plus petit modèle, si besoin. Et ce même outil pourrait facilement être appliqué en divertissement, par exemple pour suivre des joueurs en analytique sportive, ou des personnages dans des jeux interactifs.

10. Devant la diversité des sujets couverts à ICML, y a-t-il d’autres découvertes qui vous jugez prometteuses pour l’avenir, et qui méritent d’être mis en lumière ?

Olivier : Un concept intéressant que je suis content d’avoir découvert est «Memorization Sinks: Isolating Memorization during LLM Training ». Cela pourrait être un jalon important vers l’objectif de favoriser la généralisation, que beaucoup d’entre nous cherchent à atteindre. L’idées est d’activer ou de désactiver de groupes de neurones assignés à des documents spécifiques (exemples d’entraînement), ce qui encourage la mémorisation à « s’ancrer » dans ces neurones actifs uniquement pour cet exemple, tandis que les concepts généraux sont captés par ceux qui restent actifs à travers les tâches.

Sherry : Une présentation qui m’a beaucoup intriguée est « When good data backfires: Questioning Common Wisdom in Data Curation». L’article Overtrained Language Models Are Harder to Fine-Tune montre que, bien que plus de données de pré-entrainement améliorent les modèles de base, cela peut nuire aux performances en aval, un phénomène appelé surentraînement catastrophique. À mesure que les données de pré-entraînement augmentent, les modèles qui en résultent deviennent plus sensibles au bruit, ce qui peut entraîner de moins bonnes performances après l’étape de fine-tuning ou de quantification.